El pasado 20 de diciembre OpenAI presentó los resultados de su último modelo de lenguaje, o3, y la reacción en redes sociales ha sido tremenda, con comentarios hablando la llegada de la AGI (Artificial General Intelligence) como los siguientes:

“Esto lo cambia todo”

“Estamos a las puertas de la AGI”

“OpenAI revela su primera AGI”

“Si estás estudiando informática… deja de hacerlo porque programar no servirá de nada”

“Esto es más importante que el descubrimiento del fuego”

“o3 tiene un IQ similar a Einstein”

“Dios no creó a los humanos. Los humanos crearán a Dios”

No exagero, todo esto son comentarios que he visto en la red X. Aunque voy a evitar citar perfiles concretos porque no quiero aumentar el ya alto nivel de confrontación de esta red social, y estoy observando incluso ataques a los científicos y expertos que están intentando poner un poco de moderación en este delirio.

En lo personal, yo ya me siento algo hastiado por este tipo de afirmaciones, porque no es ni la primera, ni creo que será la última ocasión en la que presenciamos una situación así. Aunque me he planteado montar yo también una bronca en X, creo el formato de esta red no ayuda en nada a tratar de mantener diálogos razonados. Así que en su lugar vuelvo a este formato de artículos para explicar de forma más pausada cuál es mi punto de vista de la situación, cómo hemos llegado aquí y qué implicaciones tiene lo ocurrido.

Dado que la exposición es larga, he decidido dividirla en varios artículos. En este primero vamos a analizar un poco la historia de la IA hasta la fecha, para comprobar qué podemos aprender de ella.

Un repaso a los “hypes” y batacazos de la IA

“Quienes no pueden recordar su historia están condenados a repetirla”

Jorge Agustín Nicolás Ruiz de Santayana y Borrás

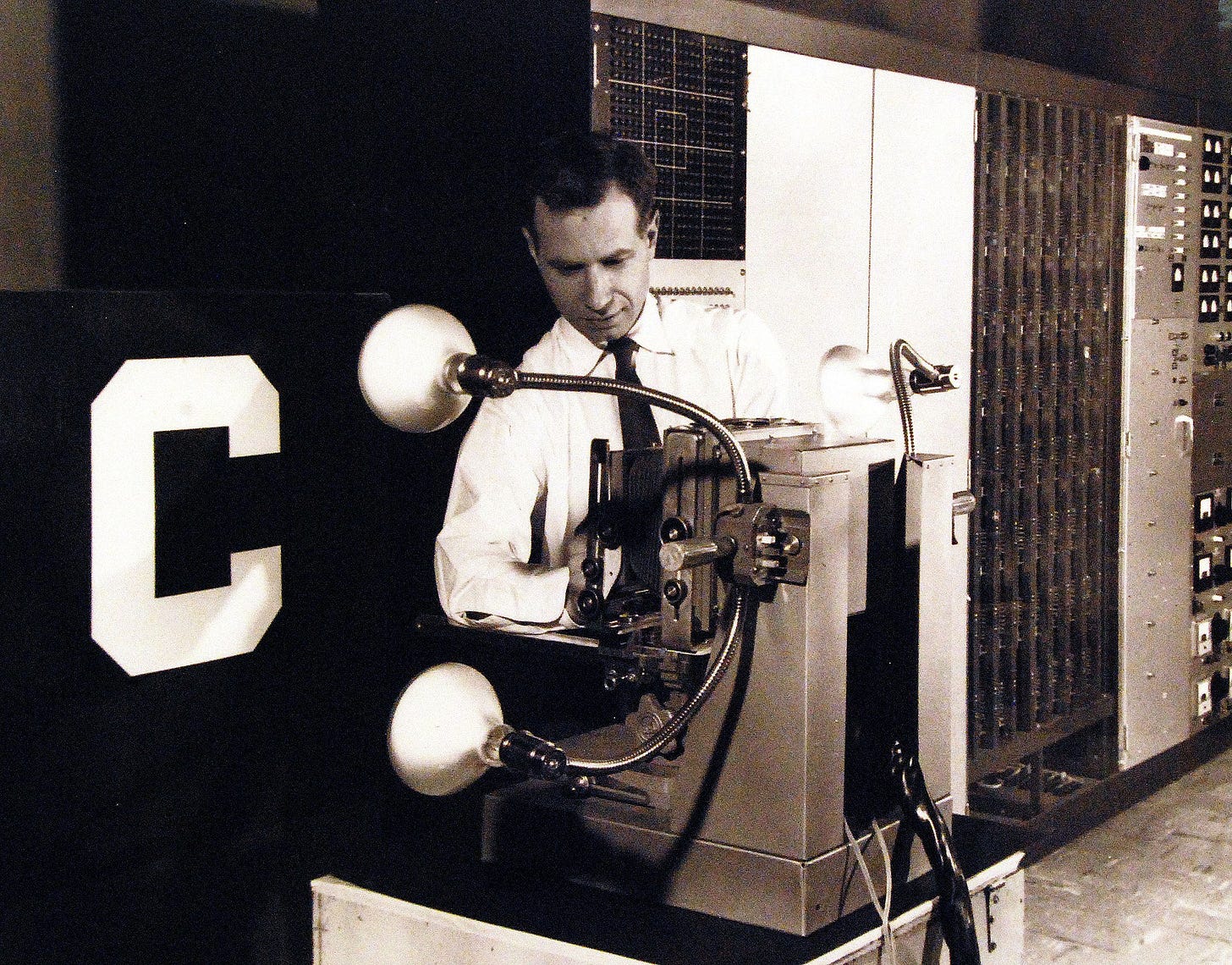

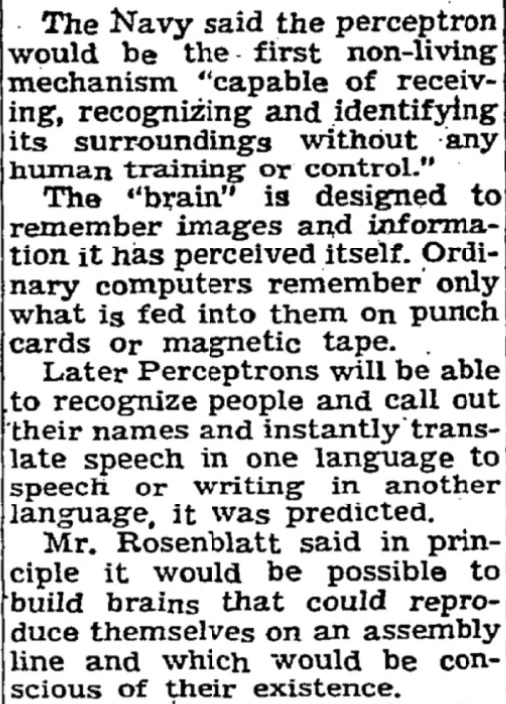

1958

Frank Rosenblatt realiza una demostración pública del perceptrón, una de las primeras redes neuronales artificiales, capaz de aprender a clasificar imágenes sencillas entre dos categorías. Su construcción supuso un coste de 2.000.000$, y la demostración resultó un éxito, incluyendo las siguientes declaraciones de la marina de los Estados Unidos (financiadores del proyecto): “el perceptrón será el primer mecanismo no viviente capaz de recibir, reconocer e identificar su entorno sin ningún tipo de entrenamiento humano o control. […] En el futuro los perceptrones serán capaces de reconocer personas y llamarles por su nombre, y traducir instantáneamente entre idiomas hablados o escritos”. El propio Rosenblatt añadía que “en principio debería ser posible construir cerebros que puedan reproducirse a sí mismos en una cadena de montaje, y que sean conscientes de su existencia”.

❌En el famoso libro histórico Perceptrons se demostró que los perceptrones sufrían de limitaciones fundamentales que les impedían aprender funciones mínimamente complejas, concretamente cualquier función no lineal. Debido a esta decepción el campo de la IA cayó en un periodo de recortes en financiación, el conocido como primer invierno de la IA, tras el cual se abandonaron las redes neuronales hasta la década de 1980.

✅Probablemente el perceptrón fue la primera red neuronal artificial capaz de aprender de forma práctica y en base a datos a resolver un problema, y sentó las bases de las redes neuronales de la actualidad. Los modelos lineales que empleamos a día de hoy para resolver muchos problemas sencillos son equivalentes al perceptrón.

1959

Se acuña el término “Inteligencia Artificial” en una conferencia de verano de la universidad de Dartmouth. Basándose en teorías previas sobre probabilidad, lógica, estadística y electrónica, se pensaba que en breve sería posible construir máquinas que pudieran traducir entre idiomas o demostrar teoremas.

❌Las perspectivas de desarrollo de la IA no se cumplieron hasta casi 60 años después, y aún tenemos trabajo por hacer.

✅Las ideas que se discutieron en esta conferencia fueron los cimientos necesarios para el desarrollo de los sistemas inteligentes de hoy día.

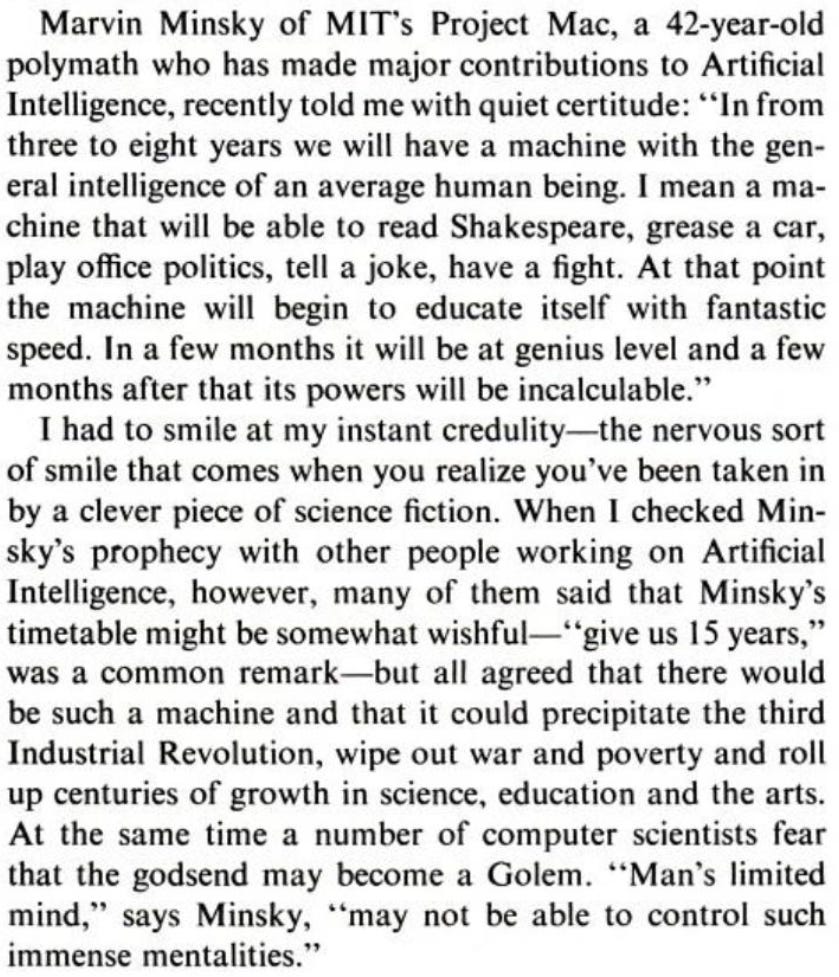

1970

Se presenta el robot Shakey, capaz de recibir una serie de instrucciones limitadas en lenguaje natural, procesarlas, y ejecutar movimientos a lo largo de una sala para cumplir esas instrucciones. La revista LIFE lo presentó como la “primera persona artificial”, y en el artículo recogían el testimonio del experto en IA Marvin Minsky, afirmando que en un plazo de 3-8 años tendríamos una máquina con la “inteligencia general de un ser humano medio, capaz de leer a Shakespeare, engrasar un coche, manejar las relaciones en una oficina, contar un chiste o meterse en una pelea. En ese punto la máquina podrá empezar a enseñarse a sí misma, en unos meses tendrá el nivel de un genio, y unos meses después su poder será incalculable”. Otros expertos consultados fueron algo más cautelosos: se necesitarían 15 años, pero para entonces se precipitaría la tercera revolución industrial, se acabarían las guerras y la pobreza, y durante siglos tendríamos un crecimiento en las ciencias, la educación y las artes.

❌15 años después ni Shaky ni sus sucesores desarrollaron inteligencia general, y las guerras y la pobreza siguen existiendo. Hoy día Shaky ha quedado como una pieza de museo.

✅En el proyecto se desarrollaron algoritmos clave para la IA, como el algoritmo A*, el cual se sigue usando a día de hoy en planificación de rutas dentro de videojuegos, o la transformada de Hough para extraer características útiles de una imagen.

1996

El ordenador Deep Blue de IBM consigue ganar en una partida a Gary Kaspárov, logrando así el hito de ser la primera máquina en vencer a un campeón mundial vigente de ajedrez. Deep Blue funcionaba en base a reglas y heurísticas creadas por ingenieros y jugadores expertos, y que aprovechaba una capacidad de cálculo masiva para evaluar unas 200 millones de jugadas por segundo. Este sistema se consideró un hito de la Inteligencia Artificial, puesto que jugar al ajedrez a nivel experto se estimaba como una tarea que requería un alto nivel de inteligencia.

❌El tiempo ha demostrado que los sistemas basados en reglas son efectivos para resolver problemas concretos, pero no generalizan a otros problemas.

✅Los desarrollos hardware y software que permitieron la paralelización masiva de cálculos demostraron ser útiles, y hoy en día se siguen empleando estrategias de esta índole para resolver problemas complejos.

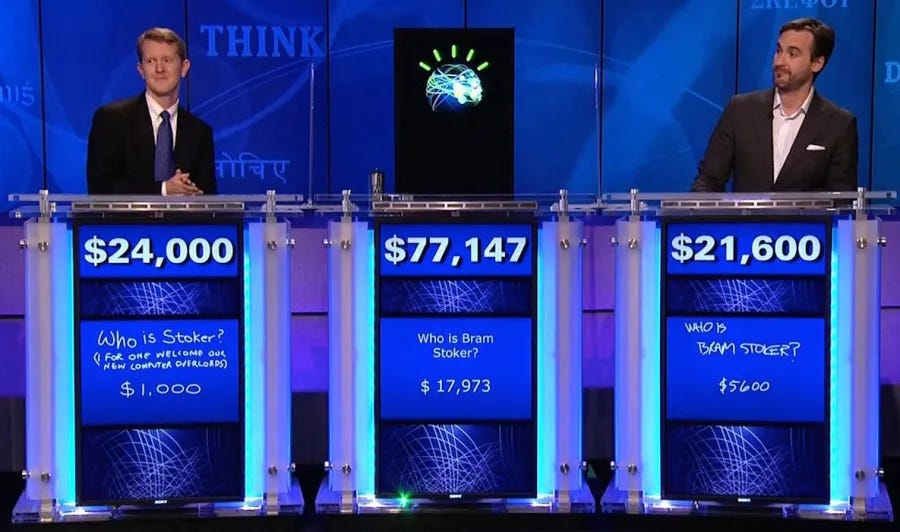

2011

El sistema IBM Watson demuestra unas capacidades sin precedentes en procesamiento del lenguaje natural y recuperación de información, consiguiendo vencer a dos campeones (Brad Rutter y Ken Jennings) en el popular concurso televisivo Jeopardy!. Tras la victoria de Watson, Ken Jennings escribió en su pantalla “Yo, por mi parte, doy la bienvenida a nuestros nuevos señores, los computadores“ (“I for one welcome our new computer overlords”), probablemente con tono jocoso. Pero lo cierto es que IBM se tomó esta victoria como algo muy real, iniciando una multimillonaria campaña de marketing en la que proponía algunos usos tremendamente avanzados de esta tecnología: hacer de asistente por voz a directivos de compañías, de forma que pudieran pedirle informes o recomendaciones de gestión en tiempo real, o incluso “resolver el cáncer”.

Por desgracia, trasladar los éxitos de un concurso televisivo en un entorno controlado a la complejidad de un problema real como el cáncer demostró ser extremadamente complicado, y a pesar de grandes inversiones y colaboraciones con centros oncológicos de prestigio, Watson no consiguió la revolución que prometía.

❌Aún logrando superar un desafío muy complejo, la realidad demostró ser mucho más compleja de lo previsto, y la tecnología no pudo realizar ese salto.

✅Aunque la tecnología detrás de Watson era propietaria, y por tanto opaca, el proyecto demostró que era posible construir sistemas automáticos capaces de procesar bases de datos masivas y responder a preguntas en el lenguaje natural.

2016

El sistema AlphaGo consigue vencer a uno de los mejores jugadores de Go del mundo, Lee Sidol. Este sistema se basaba en un pre-entrenamiento por aprendizaje supervisado sobre bases de datos de partidas de jugadores maestros, seguido por técnicas de aprendizaje y por refuerzo y el método de Monte Carlo Tree Search para seguir mejorando en base a jugar partidas contra sí mismo.

Además, tan solo un año después (2017) se presentó AlphaZero, una mejora del sistema original que logró alcanzar un rendimiento aún mejor y sin emplear la base de datos de jugadas de pre-entrenamiento, esto es, sin conocimiento humano experto. Esto demostró un cambio de paradigma en el aprendizaje automático, hasta entonces basado eminentemente en datos, ya que se podían conseguir rendimientos sobrehumanos mediante la pura interacción del sistema de IA con la tarea a resolver. ¿Habíamos encontrado por fin la fórmula a la auténtica Inteligencia Artificial?

❌Desafortunadamente, el aprendizaje por refuerzo ha demostrado estar fundamentalmente limitado por la posibilidad de simular en un ordenador la tarea a resolver de manera fiel. Siendo esto factible para juegos de mesa o videojuegos muy complejos (DoTA, StarCraft 2), resulta inviable para la gran mayoría de tareas del mundo real.

✅El aprendizaje por refuerzo sí ha demostrado aplicaciones muy efectivas en campos como la predicción de pliegues de proteínas, el aprendizaje de políticas de control de robots sencillos, o el ajuste de modelos de LLMs según preferencias humanas.

2022

A finales de 2022 OpenAI publica ChatGPT, consiguiendo 100 millones de usuarios en 2 meses, y haciendo así patentes para el público general todos los avances en IA acumulados durante las últimas décadas, pero especialmente los últimos años. Y también se da el pistoletazo de salida a la carrera frenética de LLMs que hemos estado presenciando desde entonces, donde gigantes tecnológicos como Google o Microsoft se unen a la contienda.

Y es que en los últimos años la comunidad de la IA parece haber estado sujeta a un delirio febril, en el que aún seguimos. Como muestra, nos hemos encontrado en prensa declaraciones abracadabrantes como las siguientes:

Un ingeniero de Google asegura que su compañía ha creado un programa que tiene consciencia y siente.

Facebook tuvo que apagar una IA que desarrolló su propio idioma.

ChatGPT ya sabe cuál es la terminación del premio gordo de la lotería de Navidad.

❌ChatGPT no ha reemplazado a los programadores ni a ningún profesional en su campo de experiencia, ni ha supuesto un “riesgo nuclear”, ni tampoco tiene consciencia o razonamiento. En cambio es bien sabido que sufre de alucinaciones e inventa resultados.

✅Los LLMs han demostrado ser un avance tremendo en el campo de la IA, mejorando sustancialmente la traducción automática y la búsqueda en bases de datos masivas. También un gran apoyo en actividades de desarrollo de software y elaboración y tratamiento de documentos, así como su uso general para cuestiones diarias.

¿Qué hemos aprendido de todo esto?

Por las noticias que nos desbordan cada vez que aparece un nuevo LLM, parecería que no hemos aprendido nada. Pero si analizamos el patrón de los hechos que he compartido en este artículo, veremos lo siguiente:

✅En todos los casos se produce un avance real en la ciencia o la técnica de la IA.

✅Este avance conlleva conseguir resultados rompedores en algún tipo de desafío técnico o demostración pública, incluso resolviendo ese desafío por completo, de forma que deja de ser un problema para el que sea necesario buscar soluciones.

❌Las consecuencias a medio plazo de ese avance se sobrestiman, hasta el punto de que esas consecuencias llegaron décadas después, o aún no han llegado. Esta sobrestimación puede ser debido a una mala predicción de los creadores, que no son conscientes del enorme salto que existe entre la ciencia de laboratorio y las aplicaciones reales. Pero incluso si son conscientes, esta sobrestimación también está alimentada por objetivos de marketing, llamadas a la inversión, o sensacionalismo en los medios.

❌Al no cumplirse los pronósticos, en el caso mejor estos quedan en el olvido, y los errados profetas hacen mutis por el foro. En el caso peor se produce una decepción general en la sociedad, que resulta en una interrupción de la financiación de la IA, y por tanto del avance de este campo.

✅Pero en todos los casos quedan técnicas, algoritmos y conocimientos que son de utilidad, tanto para crear soluciones prácticas a corto plazo como para la siguiente generación de descubrimientos.

Creo que reconocer este patrón es fundamental, sobre todo para los que nos dedicamos a resolver problemas con IA. El hype no es una mera burbuja vacía: si apartamos la paja existe grano, y este es el que nos permite construir soluciones prácticas.

El análisis continúa en los siguientes artículos:

*Imágenes de apoyo creadas con el modelo FLUX.1 Schnell.