La engañosa aceleración exponencial de la IA

Sobre cómo una aparente aceleración exponencial se basa en sucesivas mejoras sigmoidales y una mayor inversión

En el artículo anterior comentábamos sobre la historia de la IA, los excesos de expectativas y las consecuentes decepciones. Hoy vamos a analizar la supuesta evolución exponencial en capacidades de la IA.

Aceleración exponencial basada en mejoras incrementales

Es innegable que en los últimos años los avances en IA se han sucedido a una velocidad vertiginosa, que se han trasladado a toda la sociedad. Esta cadena de espectaculares resultados ha cristalizado en movimientos sociales como el aceleracionismo efectivo, que en resumidas cuentas pone su fe en que seguir propiciando estas mejoras exponenciales en tecnologías como la IA nos llevará a resolver problemas fundamentales de la humanidad: el cambio climático, las guerras o la pobreza.

Hay muchos indicadores que revelan cómo la calidad de vida de las personas ha mejorado sustancialmente en los últimos dos siglos, guardando esto una fuerte relación con el desarrollo científico y tecnológico:

La esperanza media de vida ha pasado de los ~30 años a los ~75 años.

La mortalidad infantil se ha reducido del 30% a menos del 1%, y la mortalidad maternal durante el parto del 0.9% al 0.005%.

La insuficiencia de alimentos en países desarrollados se ha reducido del 34.75% al 12.9% (aunque siguen existiendo muchas zonas del mundo con graves problemas).

Se ha incrementado significativamente la eficiencia (producción / hectáreas) en el cultivo de alimentos básicos como el arroz, el trigo o las patatas.

La pobreza extrema (menos de 2.15$/día) se ha reducido del 75% al 10%.

Y también ha habido mejoras en muchas otras métricas como el nivel educativo o la tasa de vacunación frente a enfermedades.

No obstante, la mejora en todos estos índices no implica la erradicación total de los problemas subyacentes. Y además, sostener estas mejoras en calidad de vida también ha requerido un aumento en la producción de energía.

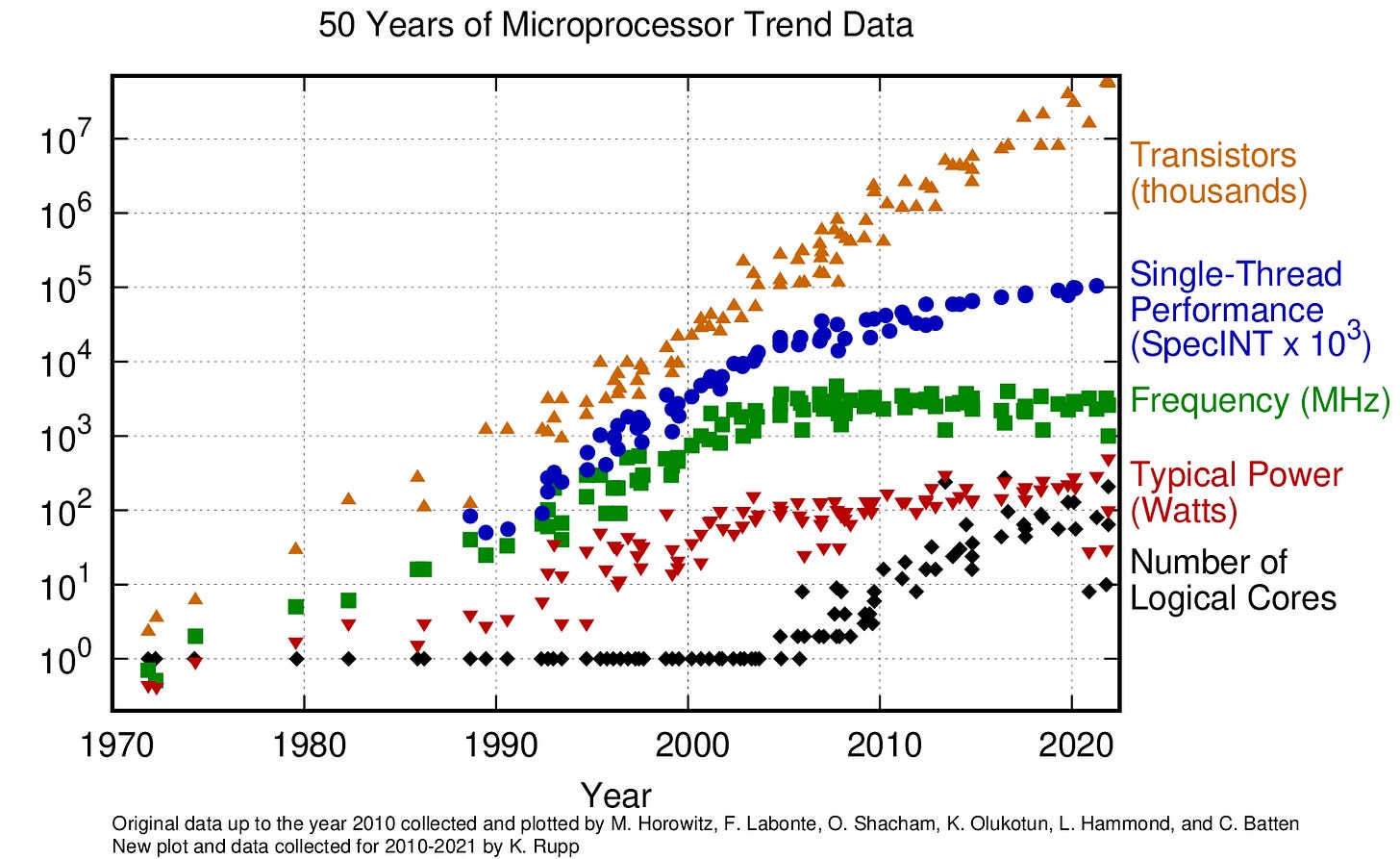

Cuando uno es un observador externo al desarrollo de algunas tecnologías ciertamente puede observarse un crecimiento exponencial en sus capacidades. Un caso típico es el de la ”Ley” de Moore, enunciada por Gordon E. Moore en 1965, la cual pronosticaba que el número de transistores de los microprocesadores se duplicarían cada 2 años. El señor Moore no se equivocó: 60 años después su “ley” se sigue cumpliendo.

Pero si analizamos un poco el detalle la gráfica anterior nos daremos cuenta de algo peculiar, y es que algunas características de los microprocesadores han saturado, y otras han aparecido recientemente. En torno a 2005 la velocidad en MHz de los procesadores se estancó, y las mejoras en rendimiento monohilo empezaron a amortiguarse. Por otro lado, surgió una nueva tendencia de aumentar el número de núcleos de cada procesador. O sea, que aunque nuestros microprocesadores siguen mejorando, ahora lo hacen empleando estrategias de cálculo en paralelo que antes no existían. Aunque a nivel global la mejora sigue siendo exponencial, esto ha requerido de cambios de paradigma y nuevas tecnologías. Y esto sin tener en cuenta los detalles de todas las optimizaciones y mejoras diferenciales que se incluyen en cada nueva generación de microprocesadores.

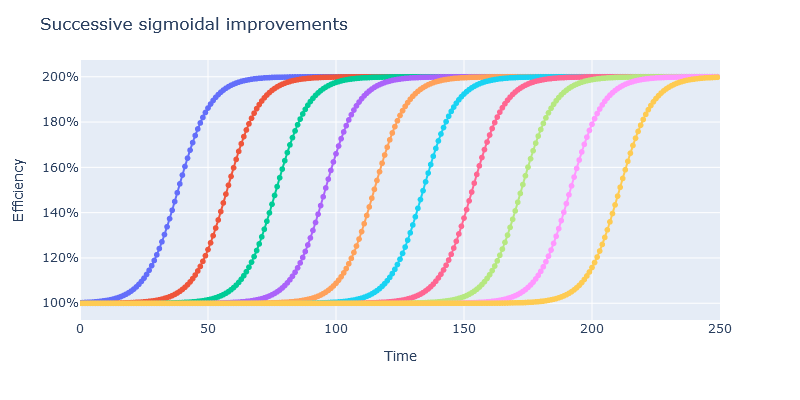

Esta misma regla aplica a todas las tecnologías, y en particular al desarrollo de la IA: aunque a nivel macro pueda apreciarse una mejora exponencial en la tecnología, al aumentar el nivel de zoom observamos que esta mejora exponencial es el efecto multiplicativo de múltiples innovaciones y cambios de paradigma, cada uno de ellos con un impacto limitado. De hecho, mi intuición es que cada uno de estos pasos de mejora sigue una forma sigmoidal: los avances son costosos y lentos al inicio, para después despegar y conseguir mejoras significativas en poco tiempo, y finalmente saturarse y ofrecer solo mejoras marginales a alto coste. Esta idea no es nueva: ya hace años leí una tesis similar de la mano del profesor Manuel Alfonseca. No obstante, difiero en sus ideas en que creo que el efecto multiplicativo de muchas mejoras sigmoidales nos lleva a una mejora global exponencial.

Podemos ver todo esto en el siguiente ejemplo: supongamos que a lo largo del tiempo se desarrollan una serie de mejoras sucesivas, cada una de ellas pudiendo aumentar la eficiencia de un proceso al doble, y estas mejoras siguen una relación sigmoidal entre el tiempo invertido en ellas y la eficiencia conseguida:

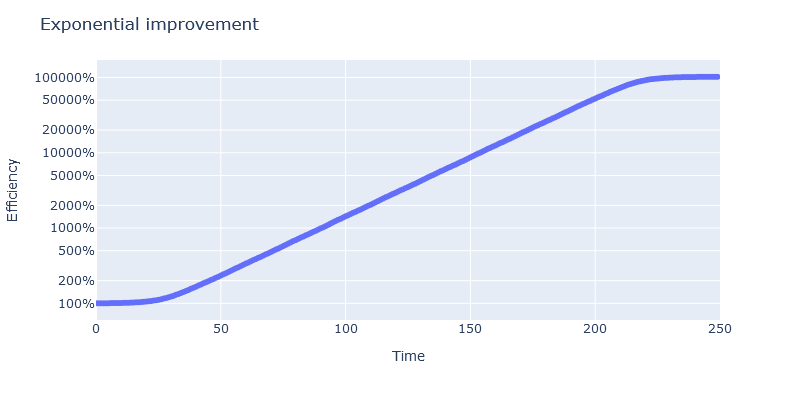

Si todas estas mejoras pueden aplicarse sin fricciones al proceso que estamos optimizando su efecto su multiplica, y al considerar el rendimiento conjunto observamos una aceleración exponencial:

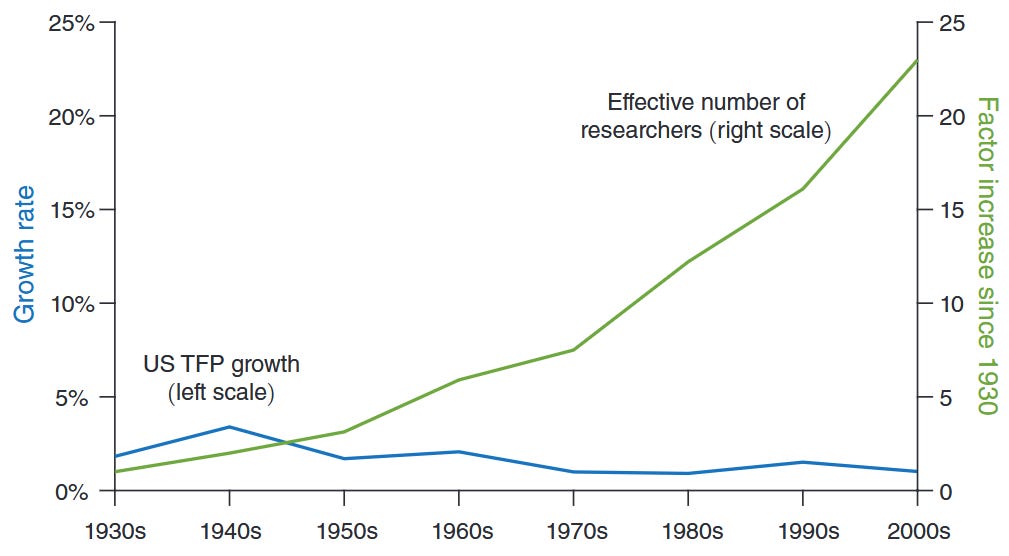

El resultado es que tras haber introducido 10 innovaciones que doblaban la eficiencia del proceso nos encontramos con un proceso 1024 veces más eficiente. Y al haber ocurrido estas de manera solapada en el tiempo, el efecto macro es una aceleración exponencial. No obstante, no debemos perder de vista que esta aceleración no es el resultado de una única mejora que se retroalimenta, sino de una sucesión de mejoras pequeñas, cada una de las cuales requiere de inversión, nuevas ideas y un consumo mayor de energía. De hecho, ya en 2020 un análisis de investigadores de Stanford señalaba que la ley de Moore se está cumpliendo a costa de cada vez mayores costes en investigación: los nuevos desarrollos requieren 18 veces más investigadores que en 1970. Esto a su vez conlleva que la eficiencia de los esfuerzos de investigación para encontrar nuevas ideas ha venido disminuyendo.

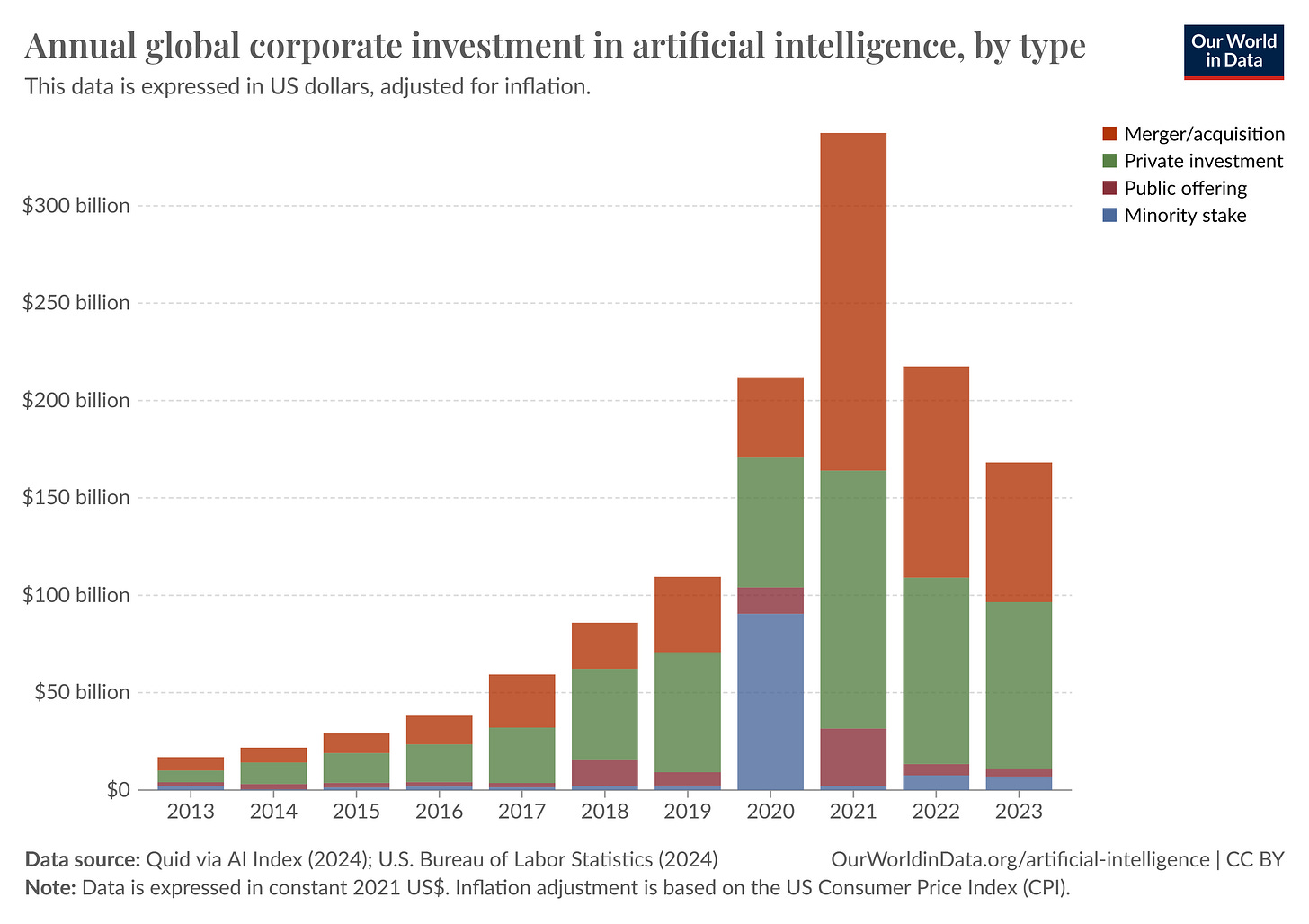

El campo de la IA y los LLMs no es ajeno a esta evolución: es evidente que los desarrollos e innovaciones se han acelerado, pero la inversión también ha crecido muy significativamente en los últimos años:

¿Por qué esto es importante?

Cabría argumentar que todo esto está muy bien, pero que si el efecto neto es un crecimiento exponencial, entonces los aceleracionistas tienen razón. Pero comprender los fenómenos subyacentes que crean esta aceleración nos permite detectar los puntos flacos en esta evolución:

El crecimiento exponencial requiere de innovaciones constantes, cada una de ellas con saturación rápida. Desconocemos cuántas de estas innovaciones son posibles, y si es que se agotarán en algún momento.

Incluso si no se agotan, el coste en recursos de cada innovación es superior a la anterior.

Es por ello que creer en una evolución exponencial infinita parece una postura demasiado optimista. Lo razonable en la situación actual es creer que la IA seguirá mejorando, sí, pero a costa de mayores inversiones. Y sin la garantía de que mejore hasta alcanzarnos o sobrepasarnos.

En el siguiente y último artículo de la serie analizaremos concretamente los resultados presentados por el modelo o3:

*Imágenes de apoyo creadas con el modelo FLUX.1 Schnell.